Opzetten basis virtualisatie-infrastructuur

Inleiding

In dit labo gaan we aan de slag met servervirtualisatie. Jullie zetten een High-Availability (HA) Proxmox Virtual Environment (PVE) cluster op met twee (of drie) fysieke servers. Dit labo introduceert essentiële concepten van servervirtualisatie, zoals live migratie en redundantie. Er zal ook aandacht gegeven worden aan het configureren van redundante netwerken via Bonding en VLANs, en het integreren van iSCSI voor gedeelde opslag (Shared Storage).

Uiteraard zullen netwerken een heel belangrijke rol spelen voor zowel de werking van de Hypervisors als voor de virtuele machines die er zullen op draaien.

De netwerkswitch, waarop jullie hosts moeten op aangesloten worden, is vooraf geconfigureerd met trunk poorten die alle benodigde VLANs dragen.

Er is echter géén dynamisch aggregatieprotocol (zoals LACP/PAGP) actief. Dit vereist een bewuste keuze voor de juiste Bonding Mode op de Proxmox-nodes (zie verder).

Doelstellingen

Na dit practicum zullen jullie in staat zijn:

- Fysieke servers te initialiseren en te installeren via out-of-band management (iDRAC).

- Een redundante Netwerk-Bonding op te zetten die past bij de switchconfiguratie.

- Het verkeer op te splitsen met VLANs voor beheer, opslag en gastnetwerken.

- Een Proxmox PVE cluster te configureren.

- iSCSI Shared Storage te integreren.

- De werking van Live Migratie en High Availability (HA) te demonstreren.

Benodigdheden

- 2x (of 3x) Dell Servers met iDRAC-toegang (Proxmox nodes).

- 1x Netwerkswitch (met vooraf geconfigureerde trunkpoorten).

- Netwerkkabels.

- Installatiemedia voor Proxmox VE (ISO).

- Toegang tot een SAN met iSCSI Target => Qnap Storage.

Adrestabel

Via deze link vind je een tabel met de toewijzing van de verschillende servers en bijhorende IP-adressen per groepje.

Vul eerst, op basis van het overzicht in de spreadsheet, onderstaande tabel aan…

Tabel met IP-adressen en netwerken

| ILO/iDRAC | Host network (Hypervisors) | VM network (Guests) | Storage network | Live Migration network | |

|---|---|---|---|---|---|

| vlan 68 | vlan 69 | vlan 70 | vlan 410 | vlan 800 | |

| SERVER1 | 10.129.68... | 10.129.69.../24 | - | 100.100.100.../24 | 172.16.254.../24 |

| SERVER2 | 10.129.68... | 10.129.69.../24 | - | 100.100.100.../24 | 172.16.254.../24 |

| SAN | - | - | - | 100.100.100.101/24 en 100.100.100.102/24 | - |

| - | - | - | - | - | - |

DNS-servers: 10.129.28.232 en 10.129.28.230

Deel 1: Voorbereiding & Basisinstallatie

Out-Of-Band Management: iLO, iDRAC, BMC, IPMI

BMC

De meeste servers in een datacenter beschikken over een BMC (Baseboard Management Controller). De BMC is het fysieke hardwarecomponent (interfacekaart) op het moederbord dat out-of-band management mogelijk maakt. Deze component staat eigenlijk volledig los van de serverhardware en beschikt over een eigen netwerkverbinding, CPU en geheugen.

De BMC voert opdrachten uit zoals "reboot", "lees temperatuur", of "start console".

IPMI (Intelligent Platform Management Interface)

IPMI is een standaardprotocol waarmee je met de BMC communiceert.

Het definieert hoe je hardwareinformatie kunt opvragen of acties kunt uitvoeren (bijv. via ipmitool).

Wordt vooral gebruikt in oudere of generieke omgevingen.

iLO en iDRAC

Dit zijn fabrikant-specifieke implementaties van een BMC:

- iLO (Integrated Lights-Out) → van Hewlett Packard Enterprise (HPE)

- iDRAC (Integrated Dell Remote Access Controller) → van Dell

Ze bieden een webinterface, KVM-console, virtuele media, en vaak extra functies bovenop IPMI.

Fysieke Bekabeling & Initiële Configuratie

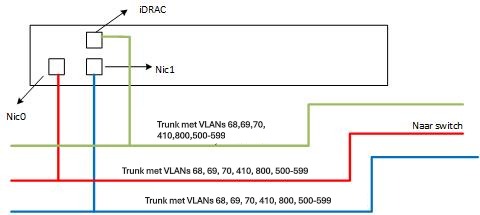

Elke server heeft 3 of meer netwerkkaarten. Kies bij voorkeur de netwerkkaarten die "on-board" zitten.

Op de poorten van de switch waarmee de servers verbonden zijn, zijn verschillende VLANS aanwezig via trunks. Afhankelijk van de fysieke poort op de servers of virtuele switches en VM’s zullen er andere VLANS van toepassing zijn.

- Sluit de twee fysieke netwerkkaarten (NICs) van elke server aan op de switchpoorten.

- Connecteer ook de iDRAC poort met de switch. Deze wordt straks gebruikt om de initiële setup en Proxmox-installatie te voltooien.

Connecteren met iDrac

De Dell servers zijn dus voorzien van die speciale BMC-kaart die toelaat

om oa. het scherm remote te bekijken.

Deze interface heet iDrac bij Dell (iLO bij HPE).

Zoek het iDRAC-adres op van je server in je adres-tabel. Door er naar te surfen met een

browser en in te loggen krijg je een overzicht van de hardware-parameters van de server.

Daarnaast kan je ook een virtual console oproepen, waarmee je een

virtueel scherm koppelt aan de server.

Daardoor kan je vanop afstand beheersacties uitvoeren, en zelfs tot op

bios-niveau aanpassingen doen.

Ook een remote installatie via een remote gekoppelde ISO wordt dan mogelijk.

Bemerking bij het overnemen van een scherm via iDRAC:

-

Bij het overnemen van het scherm is de mapping van het keyboard mogelijks fout: de letters die je intikt komen niet overeen met wat effectief op de server ingegeven wordt. Dat is vooral gevaarlijk bij het ingeven van een wachtwoord. We raden je daarom aan om een eenvoudig wachtwoord te kiezen bij de installatie van je OS, en dat uitgebreid te testen via een extra cli-console (Alt-F1 in Linux).

-

Toegang tot de console verloopt dus via je browser.

Inloggegevens Dell iDrac:

-

username: root

-

password: Azerty123

Verander dit wachtwoord niet!

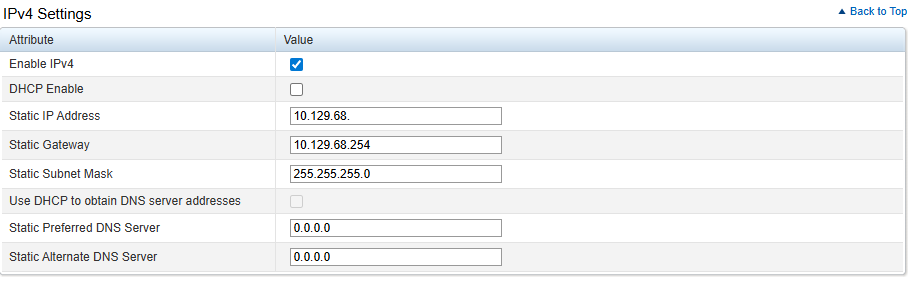

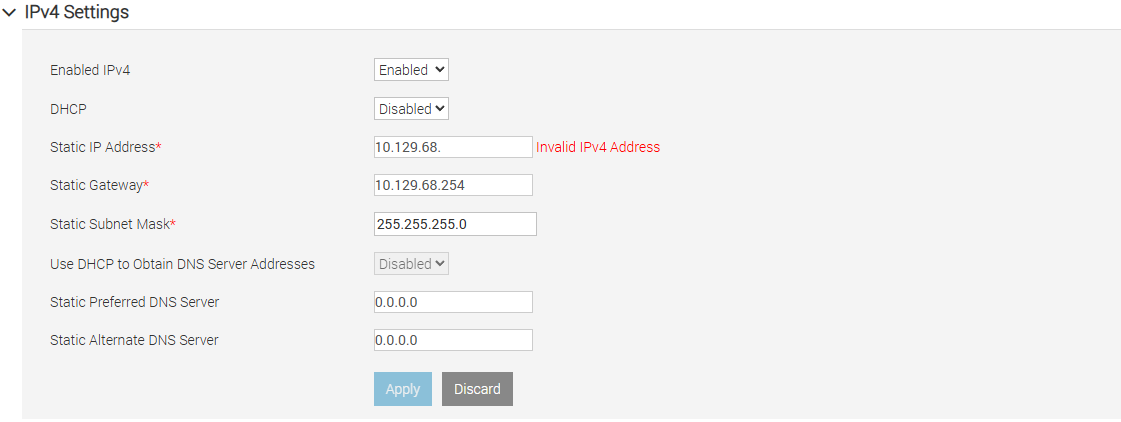

Aanpassen netwerk iDRAC - vlan wijziging

Aangezien we dit academiejaar grote veranderingen doorgevoerd hebben op het vlak van servers en netwerken in ons datacenter moet er eerst een aanpassing gebeuren voor oa. iDRAC.

Tot op heden werd een apart netwerk voorzien voor communicatie met iDRAC in vlan 16.

Dit moet wijzigen naar vlan 68!

Bij de netwerkinstellingen van je iDRAC mag je zowel het ip-adres als de vlan aanpassen naar de nieuwe waarden.

De nieuwe vlan is uiteraard vlan68. Het correcte ip-adres vind je voor jouw servers in de addressenlijst (zie hierboven)?

Er is een verschil tussen iDRAC versie 8 en versie 9.

Bij iDRAC versie 8 kan je vermoedelijk zowel het ip-adres als de vlan in één keer aanpassen en kan je normaal onmiddellijk terug connecteren op het nieuwe adres.

Bij iDRAC versie 9 kan dit niet. Bijgevolg zal je dus de connectie verliezen en zal je deze setting fysiek in het datacenter (via een tijdelijk aangesloten scherm en keyboard) moeten aanpassen.

-

iDRAC Versie 8:

-

iDRAC Versie 9:

Updaten firmware (optioneel)

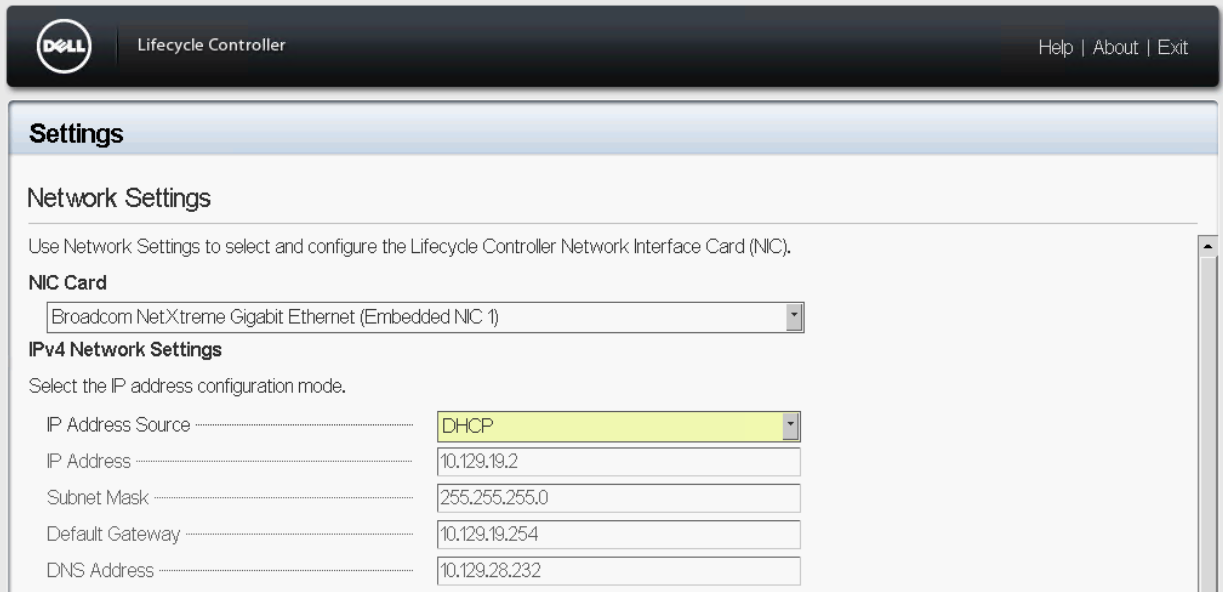

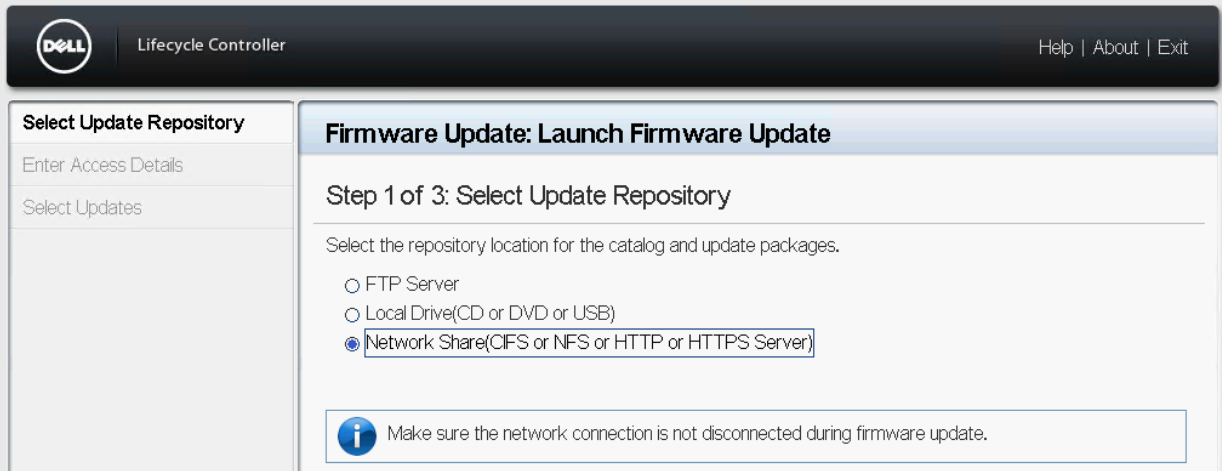

Idealiter worden alle hardware-onderdelen (Bios, storagecontrollers, netwerkkaarten, ) van de server ook voorzien van de nieuwste firmware. De meeste fabrikanten voorzien daarvoor op de een of andere manier een bootable ISO om dit vlot te kunnen uitvoeren. Bij de grote merken is er meestal ook een platform ingebouwd (naast iDrac en Bios/EFI) om dit te integreren. De firmware kan dan via een ISO of rechststreeks online binnengehaald worden. Bij Dell heet dit "Lifecycle Manager" en is te bereiken via de F-10 toets tijdens het opstarten.

Je mag ook jouw servers voorzien van de nieuwste firmware maar doe dit enkel op een moment waar je daar de tijd voor hebt. Deze handeling kan serieus wat tijd in beslag nemen (ca. 15 tot 30 minuten).

-

Eerst moet de Lifecycle Manager correcte netwerkinstellingen hebben. Hiervoor worden de "gewone" NIC's gebruikt, niet de iDrac interface! Voor het gemak mag hier een DHCP setting ingesteld worden. Dit is toch maar tijdelijk.

-

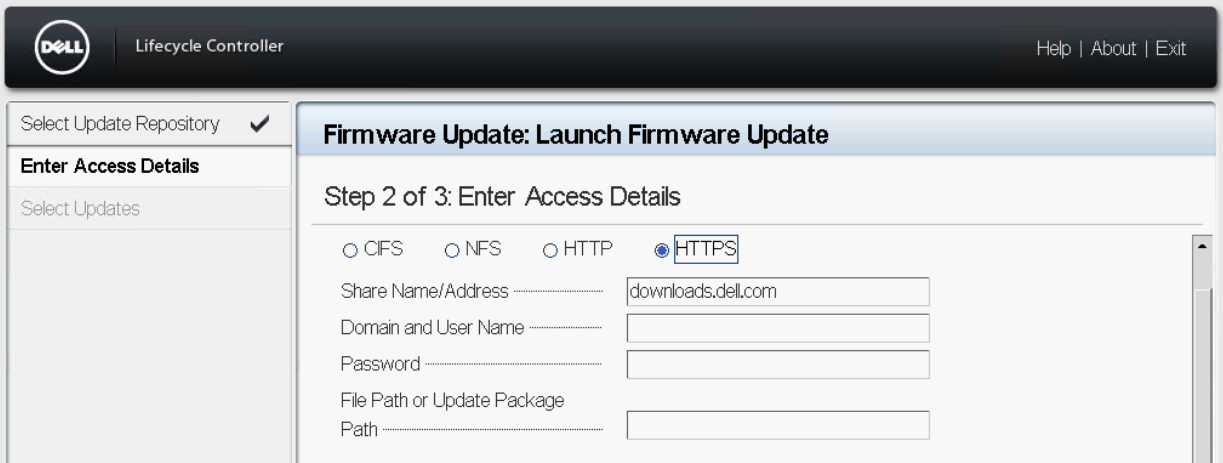

Aangezien we de updates online zullen verkrijgen, kiezen we voor HTTPS als bron en verwijzen we naar downloads.dell.com. Bij nieuwere firmwares kan ook gewoon geselecteerd worden dat downloads van Dell moeten komen, en is het niet nodig om de downloadsite expliciet op te geven.

Controleren van de lokale storage

In elk van jullie servers zitten één of meerdere schijfjes. Bekijk in je iDRAC omgeving hoeveel schijven er aanwezig zijn. Als er 2 of meer gelijkaardige schijven aanwezig zijn dan kunnen die best in RAID geconfigureerd worden om dataverlies te voorkomen in het geval 1 schijf faalt. Controleer daarom in de diskcontroller als de configuratie toelaat om een RAID configuratie in te stellen. Pas dit eventueel aan (mocht dit mogelijk zijn en nog niet het geval is)… Indien er maar 1 schijf aanwezig is, dan is bovenstaande uiteraard niet van toepassing.

Heel soms lijkt de iDrac interface geen schijven weer te geven. Dit is vermoedelijk ten gevolge van een fout in de firmware. Tijdens de installatie van je hypervisor zal je daar wellicht geen last van hebben. Je kan het ontbreken van die schijven dus wellicht gewoon negeren.

Deel 2: Installatie, Netwerkconfiguratie & Clustering

Installatie

Installeer nu Proxmox op je twee (drie) hosts.

Dit doe je door de Proxmox-ISO te koppelen in iDRAC en de installatie van daaruit te starten.

Aangezien er trunks geconfigureerd zijn op de switchpoorten waarmee je servers verbonden zijn, en je tijdens de installatie nog geen vlans kan definiëren, zal automatisch de native vlan gebruikt worden.

De native vlan is in dit geval vlan 79, voorzien van DHCP en zal dus enkel heel tijdelijk gebruikt worden om de installatie te kunnen uitvoeren.

Tijdens de installatie zal je dus bij de netwerkinstellingen een ip-adres krijgen uit de range 10.129.79.0/24.

Tijdens de installatie hoef je niet veel instellingen mee te geven, maar geef uiteraard relevante en correcte settings mee.

Na een reboot en als alles geslaagd is krijg je in de console een URL waarnaar je kan surfen om de grafische console te zien.

Netwerkarchitectuur (Analyse en Keuze)

Nu we een standaard Proxmox geïnstalleerd hebben moet er eerst nog even nagedacht worden over hoe de netwerken in deze hypervisor moeten geconfigureerd worden.

De switchpoorten zijn reeds geconfigureerd als trunks, maar er is géén LACP of PAGP (EtherChannel) geconfigureerd.

Momenteel heb je dus enkel connectiviteit via de native vlan en slecht via één netwerkkaart.

- Onderzoek: Zoek op welke Bonding Modes beschikbaar zijn in een Linux omgeving voor Link Aggregation.

- Analyse & Keuze: Bepaal welke Bonding Mode de beste balans biedt tussen redundantie en efficiëntie (throughput), rekening houdend met het feit dat de switch statisch (zonder lacp) is geconfigureerd.

- Rapportage: Noteer de gekozen Bonding Mode en motiveer kort je keuze (in je labo-notities).

Proxmox Redundante Netwerkconfiguratie (Implementatie)

Implementeer de gekozen netwerkarchitectuur op beide Proxmox nodes.

-

Redundante Basis: Configureer de twee fysieke NICs als een Linux Bond (

bond0) met de mode die jullie in de vorige stap hebben gekozen. -

Verkeerssegmentatie: Bepaal de beste methode om het verkeer op deze bond te splitsen via VLAN-tagging voor de volgende logische segmenten:

- Management Netwerk (

vlan 69: Proxmox GUI en Cluster-communicatie). - Storage Netwerk (

vlan 410: iSCSI-verkeer). - Guest Netwerk (

vlan 70: VM-connectiviteit). - Migration Netwerk (

vlan 800: VM Live Migration)

Opgelet!Het Guest Netwerk zal niet door proxmox zelf gebruikt worden. Het zijn de virtuele machines die we later zullen deployen die een netwerkkaart moeten kunnen verbinden in dit gescheiden netwerk,

vlan 70.Om dit te realiseren zijn er netwerkgewijs twee manieren. Welke?

Zorg voor een correct benadering in je proxmox-netwerkinstellingen zodat VM's deze

vlan 70gewoon als een"access port"kunnen gebruiken.

M.a.w. moet je er voor zorgen dat je VM's de vlan tag niet meer moeten mee geconfigureerd krijgen. - Management Netwerk (

-

Adres-toewijzing: Wijs de correcte statische IP-adressen toe aan de interfaces voor het Management Netwerk, het Storage Netwerk en het Migration Netwerk* op beide nodes, binnen de juiste VLAN's.

tipIn Linux kan je typisch maar één default gateway opgeven. (Waarom?)

Denk even na op welke interface je een default gateway zal meegeven.

Cluster Opzetten

- Controleer de netwerkconnectiviteit tussen de twee Proxmox nodes via het Management Netwerk.

- Maak op één van de nodes een Proxmox Cluster aan en voeg de tweede node toe.

Zoek even op wat de ideale omstandigheden (voorwaarden) zijn om een cluster op te zetten.

Voldoen wij hieraan?

Wat zijn nadelen van een two-node cluster zoals in ons geval?

Wat betekent Quorum en hoeveel Quorum votes moet je (altijd) hebben?

Deel 3: Gedeelde Opslag en Diensten

iSCSI Shared Storage Integratie

- Configureer de iSCSI Initiator op beide Proxmox nodes en zorg ervoor dat deze de targets benadert via het Storage Netwerk.

- Voeg de gedeelde iSCSI Storage toe in de Proxmox GUI.

Als SAN, die we hier benaderen via het iSCSI-protocol, gebruiken we hier een QNAP-storage-device.

Dit is geen "echte" SAN, maar biedt dezelfde services aan die vooral softwarematig (linux) geëmuleerd worden.

Om de iSCSI portal (target) te kunnen benaderen gebruik je:

- Username "chap" en wachtwoord "Azerty12345678"

- ip-address: 100.100.100.101

- Zoek zelf eens op (en configureer) hoe je deze iSCSi target verder kan gebruiken om straks als gedeelde storage te fungeren voor virtuele disks van meerdere VM's.

Indien deze LUN op de SAN al eerder gebruikt werd (door vorige opstellingen), dan is het mogelijk dat je er geen bestandssysteem meer kan op definiëren.

Je zal dan zelf even moeten opsnorren hoe je deze LUN weer volledig kan wissen en als "raw disk" terugzetten;

NFS storage

Als alternatief voor block-based shared storage zoals iSCSI zou je ook een file-based storage kunnen gebruiken zoals NFS.

Wij gaan NFS hier niet gebruiken als een shared storage om de 'virtual disks' op te slaan van de VM's.

NFS gaan we in deze opstelling enkel gebruiken om ISO's voor installaties op te verzamelen.

- Configureer een NFS storage voor ISO's.

- Zorg voor een ISO van een Linux OS op deze share (Rocky Linux Minimal)

Er werd voor jullie per team een NFS-share aangemaakt die jullie kunnen gebruiken.

Deze is te vinden op ip-adres: 100.100.100.102

Opgelet: wellicht zien jullie op de NFS-server nog andere shares staan. Als alles goed is heb je enkel permissies op je eigen NFS-share.

VM Implementatie en Connectiviteitstest

- Maak een VM aan en plaats de virtuele schijf op de iSCSI-opslag.

- Verbind de VM met het Guest Netwerk.

- Valideer dat de VM connectiviteit heeft met het internet.

Koppel de ISO van de NFS-storage of kies een ander OS naar keuze om je VM te installeren en testen.

Deel 4: Essentiële Virtualisatie Concepten

Live Migratie

Zoek op hoe je er voor kan zorgen dat je Migratie verkeer over het aparte, voorzien netwerk loopt?

- Voer een Live Migratie uit van de draaiende VM naar de andere node.

- Valideer dat de netwerkverbinding van de VM ononderbroken blijft.

High Availability (HA)

- Schakel de High Availability (HA)-feature in voor de VM.

- Simuleer een falen: Schakel de node waarop de VM draait geforceerd uit (bijvoorbeeld via iDRAC).

- Controleer of de VM correct en automatisch op de resterende node wordt opgestart.

Bij het opzetten van de cluster moest je eerder al even nadenken over wat een cluster precies is en wat Quorum precies betekent.

Om HA mogelijk te maken in jullie two-node-cluster geven we jullie hier alvast een ip-adres mee om een extra �´vote´ te kunnen krijgen in de cluster.

Je zal zelf even moeten nadenken om te zien hoe je dit kan gebruiken...

- ip adres: 10.129.23.101

- username/password: root/Azerty123

Opgelet!! Gelieve niets te installeren of aan te passen op dit toestel?